5 月 30 日消息,近日 Meta 团队开发了一款名为 Megabyte 的 AI 模型以抗衡 Transformer,据称 Megabyte 解决了 Transformer 模型所面临的问题,并且在速度上提升了 40%。

▲ 图源 Arxiv

目前 Transformer 在自然语言处理等领域非常流行,但由于其序列数据的处理方式是逐步进行的,无法并行化处理,因此训练速度较慢; 难以处理长序列,因为其在反向传播过程中,梯度很容易消失或爆炸;此外,由于需要在每一步保留历史信息,内存消耗较大。

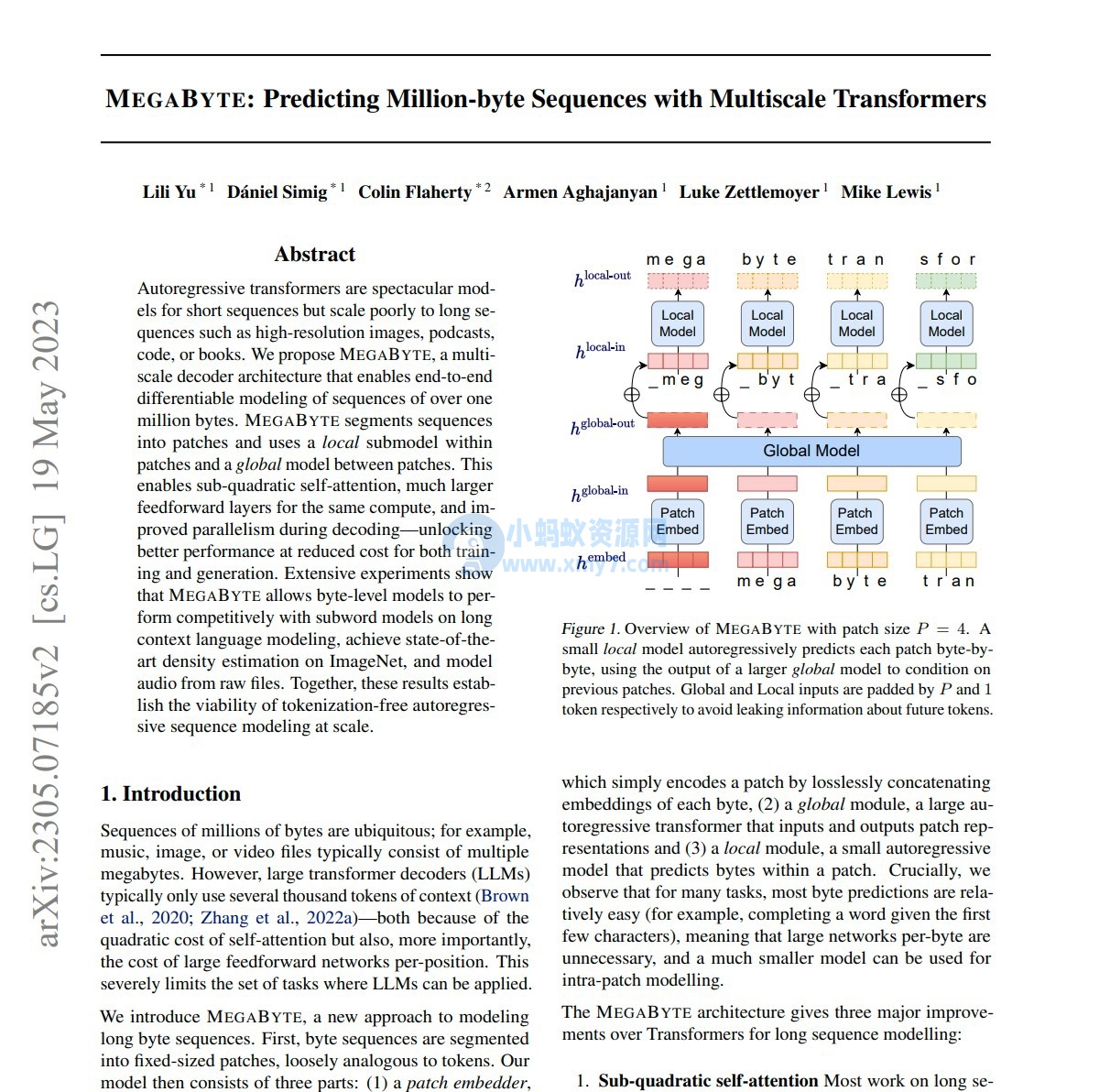

而 Megabyte 模型将输入和输出序列划分为 patch,而不是单个的 token。这种架构使得对大多数任务而言字节级别的预测相对容易,例如根据前几个字符预测完成的单词等。这意味着在大型网络中可以精简字符以提升效率,并且内部预测可以使用更小的模型进行。Megabyte 模型的这种方法解决了当今 AI 模型所面临的训练速度、可靠性及硬件占用比挑战。

▲ 图源 Arxiv

此外,在计算效率方面,相比于等大的 Transformer 和 Linear Transformer,Megabyte 模型在固定模型大小和序列长度范围内使用更少的 token。因此相对于 Transformer,Megabyte 模型可以在相同的计算成本下训练内容更丰富、体积更大、性能更好的模型。

目前 Meta 团队放出了 Megabyte 模型的论文。